文章整理自:Epoch vs Batch Size vs Iterations | by SAGAR SHARMA | Towards Data Science

梯度下降法求解:需要多次獲取結果才能獲得最佳結果

梯度下降具有稱為學習率 的參數**。** 如上方(左)所示,步長較大意味著學習率更高,隨著分數的降低,步距越短,學習率就越小。

當數據太大時,我們才需要 epochs, batch size, iterations等術語,因為我們無法將所有數據一次傳遞給計算機。為了克服資料量太大,無法一次傳給計算機的問題,我們需要將數據分成較小的大小,並一一提供給我們的計算機,並在每一步結束時更新神經網絡的權重以使其適合給定的數據。

Epochs

一整個資料集傳遞了一次,稱為一個Epoch

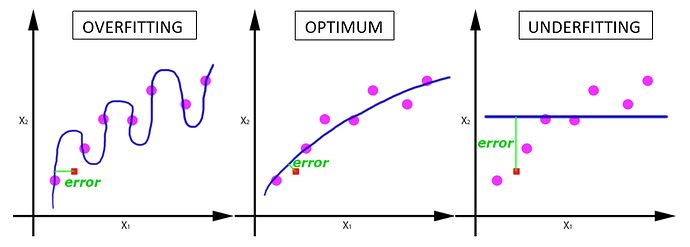

如果整個計算僅僅做一次Eposh,就會造成under fitting現象,反之,若做了過多Epochs,就會造成over fitting現象。

Batch Size

一次批次處理(batch)中,處理的資料數。

Iterations

單一一次epoch中,需要完成的batch總數。

舉例:

2000 rows need to be processed, which need

batch number: 500

iteration: 4

for 1 epoch